Wasser tut’s freilich

höher jedoch steht die Luft,

am höchsten das Licht!

Arnold Rikli

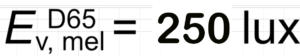

Die Lichtqualität, die man im Wirken der Organisationen wie die CIE (Internationale Beleuchtungskommission) ganz oben in der Agenda wähnt, hat es im 99. Jahr vor dem Jubiläum der V(λ)-Kurve in das Internationale Wörterbuch der Lichttechnik geschafft, das seit immerhin 1938 schriftlich vorliegt und gepflegt wird.

Bis dato definierte nämlich diese Kurve, was Lichtqualität bedeutet – Helligkeit.

Was hat das mit dem semantischen Dreieck zu tun? Viel. Es ist ein faszinierendes Konzept, das uns erklärt, wie wir Dinge verstehen oder begreifen. Oder wie wir uns einen Begriff von Dingen machen wie z.B. von der Qualität.

Das Dreieck besagt, dass zum Begreifen von etwas dieses Etwas existieren muss. So z.B. ein Fisch. Es muss relativ klar umrissen sein wie z.B. ein Garten oder ein Baum. Wird diese Voraussetzung nicht erfüllt, verstehen wir selbst täglich benutzte Dinge nicht. Dazu gehört der Computer, den manche Leute hassen. Sie schreiben diesbezügliche Ideen zuweilen auf ihrem Handy und übermitteln diese anderen auch damit. Dass ein Handy ein Computer ist und kein Telefon, wissen zwar viele. Sie verstehen es aber nicht.

Zum Verstehen von Etwas gehört nämlich ein Name, besser gesagt, eine genaue Bezeichnung. Wenn es gelingt, diese Bezeichnung präzise zu fassen, verstehen wir das Etwas besser. So ist ein bestimmter Computer, der Autoschlüssel, jedem ein Begriff. Während man unter einem PC viele Dinge vorstellen kann. Für die meisten von heute ist ein PC ein Laptop mit Display und Tastatur, in dem man Programme und Daten speichern und sich wiederholen kann. Genau die gleichen Kisten stehen aber auch bei Angestellten im Büro, sie funktionieren etwa gleich, sie sind aber etwas anderes. Sie speichern keine Daten, ihre Programme stehen auf Servern oder in der Cloud, wie manchmal die Daten auch.

Damit kommen wir zu der dritten Ecke des Dreiecks: Um das Etwas zu begreifen, benötigen wir die persönliche Begegnung damit. Ein gut geschulter Angestellter an einem Firmen-PC wird den besser verstehen als einer, der die Kiste im Schaufenster sieht. Wer gar nur das Wort PC hört, denkt an sein Gerät, so er eins gehabt hat.

Anders als das semantische Dreieck scheint das Wort Qualität jedem ein Begriff zu sein. Es ist immerhin etwa 2500 Jahre alt. Leider ist dem nicht so. Deswegen musste sogar eine Qualitätswissenschaft gegründet werden. Diese ist aber erstaunlich jung. Nach dem Zweiten Weltkrieg, insbesondere in Japan, trugen Persönlichkeiten wie W. Edwards Deming (hier) und Joseph M. Juran maßgeblich zur Entwicklung des modernen Qualitätsmanagements bei. Deming entwickelte Prinzipien der ständigen Verbesserung (PDCA-Zyklus) und 14 Managementprinzipien.

Im Westen kamen diese Ideen dadurch an, dass Japan große Erfolge damit feierte, also erst in den 1970ern. 50 Jahre gegenüber 2500? Ist Qualität so schwer zu verstehen? Die Antwort ist ja. Und daran sind die Alten schuld. Qualität ist nämlich nicht ein Begriff, sie war von Anfang an zwei Begriffe. Und auch nach der internationalen Normung in den 1980ern (ISO 9000 Reihe) blieb das Wort Qualität zweideutig.

Die eine Bedeutung der Qualität ist eine (hohe bzw. hochwertige) Beschaffenheit. Wer ein Qualitätsprodukt kauft, will eine hohe Qualität. Und die ist, was er sich darunter vorstellt. So stellt ein Porsche für viele ein Qualitätsauto dar.

Die genormte Bedeutung der Qualität ist „Erfüllen der Anforderungen“. Sie ist, was das Ingenieurswesen ausmacht, dessen Produkte weder gut noch schlecht sind, sondern für ihren Zweck geeignet oder nicht. Wer als Familienvater einen Kinderwagen für Zwillinge transportieren muss, für den ist ein Porsche bestimmt kein Qualitätsauto. Vielleicht war er es gewesen, als der Fahrer der Mutter der Zwillinge imponieren wollte.

Jeder Ingenieur, der etwas schafft, handelt i.S. der zweiten Definition der Qualität. Sein Produkt muss die Anforderungen erfüllen, die daran gestellt werden. Wer diese stellt? Das ist die große Kunst. Vor einer Entwicklung muss man sich ein Bild davon machen, was der Benutzer von dem Produkt erwartet. Die professionelle Kunst hört auf den Namen Requirements Management.

Was tut man aber, wenn die Leute nicht wissen, was sie fordern sollen? Man erfindet z.B. ein disruptives Objekt wie das Smartphone. Es hat nicht nur eine hundertjährige Branche umgeschmissen. Die Telekommunikation ist nach 2007 eine völlig andere geworden. Es hat den Weltmarkt umgeworfen. Der Marktführer für Mobiltelefone Nokia mit 38% Weltanteil war fünf Jahre danach nicht mehr existent. Und es hat Kulturen umgeworfen. Selbst Analphabeten können mit dem Smartphone Bankgeschäfte u.ä. erledigen. In Afrika läuft das Bankgeschäft für Arme über Handys. In Indien ist ein Gesundheitssystem entstanden, das darauf aufbaut.

Wie war es, als Edison die Glühlampe perfektionierte? Hat Licht als Begriff existiert? Eigentlich, ja. Man wusste vom natürlichen Licht vermutlich seit der Schöpfung der Menschheit. Das künstliche Licht war etwa 17,000 Jahre alt. Es war nur nicht perfekt (siehe Epochen der Kunst der Lichtmacher). Das Licht hatte also einen Namen. Das erste Eck vom semantischen Dreieck war also besetzt.

Hatte der Begriff Licht klare Umrisse? Hier kommt ein klares Nein. Selbst die Physik wusste nicht gerade viel über Licht. Menschen wie Einstein oder Max Planck waren zwar schon geboren, sie hatten ihr großes Werk noch nicht abgeliefert. Man hing noch der Äther-Theorie nach. Diese, die Äthertheorie, besagte, dass der gesamte Raum – auch der scheinbar leere Weltraum – von einem unsichtbaren, masselosen und allgegenwärtigen Medium, dem sogenannten "Äther", erfüllt sei. Der Äther hatte praktisch keine Masse, ließ alle Planeten ungehindert wandern, war elastischer als der härteste Stahl. Also ein Gebilde, das es hat nicht geben können. Aber große Geister wie René Descartes, Vater des kartesischen Systems, oder Isaac Newton, der Vater der modernen Physik, und auch James Clerk Maxwell, dem die Vereinheitlichung von Elektrizität, Magnetismus und Licht in einer einzigen, kohärenten Theorie gelungen war, glaubten an den Äther.

Wenn das das einzige Problem wär! Man wusste nicht einmal genau, woraus Licht bestand und welche Anteile welche Wirkungen auf den Menschen ausübten. Auch als Matthew Luckiesh sein Buch „Light and Health“ im Jahre 1926 veröffentlichte, hatten weder die Mediziner noch die Lichttechniker viel Ahnung von den Dingen, von denen sie sprachen. Daher der Versuch der CIE, mit der V(λ)-Kurve Licht zu definieren und vor allem, messbar zu machen.

Diese Kurve war so erfolgreich, dass die Präsidentin der CIE alle ihre Experten einlud, zur Jahrhundertfeier ein Gedicht zu schreiben oder wenigstens ein Kunstwerk zu erstellen. Zu erfolgreich. Denn das so definierte Licht umfasst nur einen Teil dessen, was Licht für den Menschen ausmacht. Für fast alle Pflanzen ist die Kurve sogar falsch. Und auch die meisten Tiere sehen Licht anders.

Dem so definierten Licht ist in der Natur noch nie ein Mensch begegnet. Es ist ein rein künstliches Gebilde, das einen Teil der Sehvorgänge beim Menschen erklärt, so er nicht ganz jung oder älter ist.

Wir haben trotz des Jahrhunderts des Lichts keine Chance gehabt, es zu begreifen. Es hakt an allen Ecken des semantischen Dreiecks. Daher die ganzen Irrungen und Wirrungen, von denen das Buch Genesis 2.0 – Schöpfung der elektrischen Sonne handelt.