Die Lichttechnik hat zwei Größen, die in keiner anderen Technik oder Wissenschaft vorkommen: den Raumwinkel und die Leuchtdichte. Den Ersteren erkläre ich wo anders. Wichtiger ist die Leuchtdichte, weil sie die Grundlage des Sehens bildet.

Wenn Ihnen Unangenehmes oder zuweilen Lebensgefährliches widerfährt, kann es durch ein mangelndes Verständnis dieser Größe bei Fachleuten oder dem Gesetzgeber handeln:

- Sie können nicht schlafen, weil der Nachbar aus dem nächsten Haus mit einer legal erworbenen Lampe in Ihr Schlafzimmer leuchtet, obwohl das Bundesimmissionsgesetz Sie davor schützen will

- Während einer Autofahrt an einem sonnigen Tag überfahren Sie ein Kind, das hinter einem Radfahrer die Straße überquert. Kein Richter glaubt Ihnen, dass Sie haben nichts sehen können

- Auf der Autobahn verfolgt Sie ein Fahrzeug, dessen amtlich zugelassenen Lichter stark genug scheinen, um Sie wegbeamen zu können.

Das alles und noch mehr ist möglich, weil die Leuchtdichte nicht oder falsch verstanden wird. Ihre Rolle bei der Blendung, die uns bei der Arbeit quält, hatte ich anderswo beschrieben (Beim ersten Ziel schon die Zähne ausgebissen)

Konsequenterweise gehört die Leuchtdichte in die Liste der internationalen Basiseinheiten (SI-Einheiten). Da die CIE aber aus einem Messverein entstanden war, nimmt diese Rolle die Lichtstärke ein. Sie ist eine der 7 wichtigen physikalischen Basiseinheiten. Wobei das Wort physikalisch nur halb stimmt. Sie leitet sich von der physikalischen Strahlstärke ab und wird daraus berechnet, indem man das jeweilige Licht mit der Augenempfindlichkeit bewertet. Die Lichtstärke konnte man als Erstes präzise messen und daher international normen.

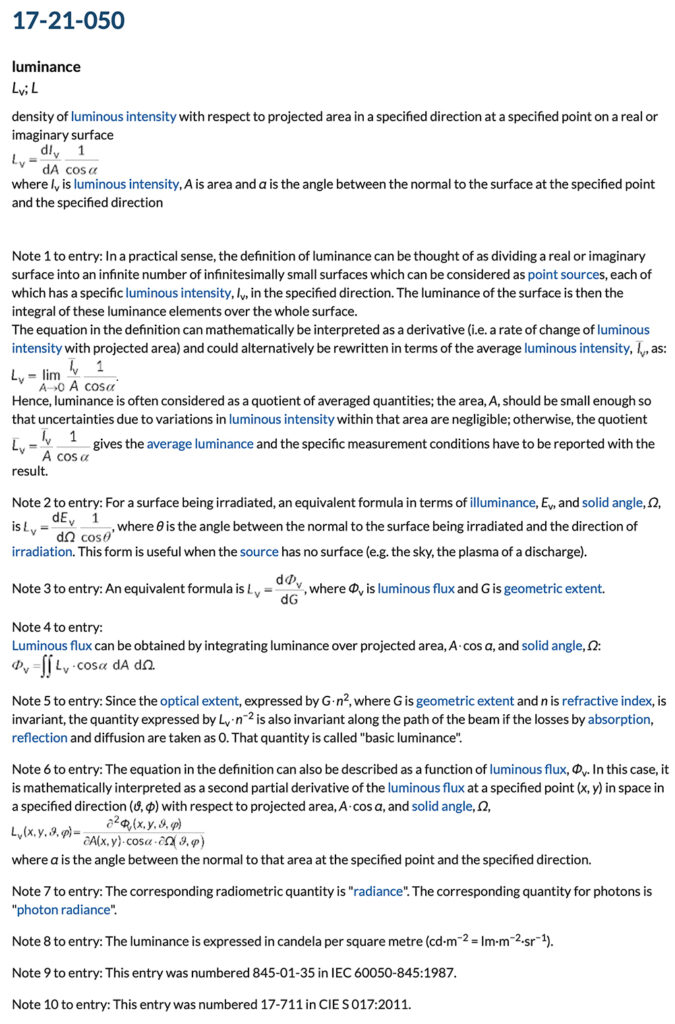

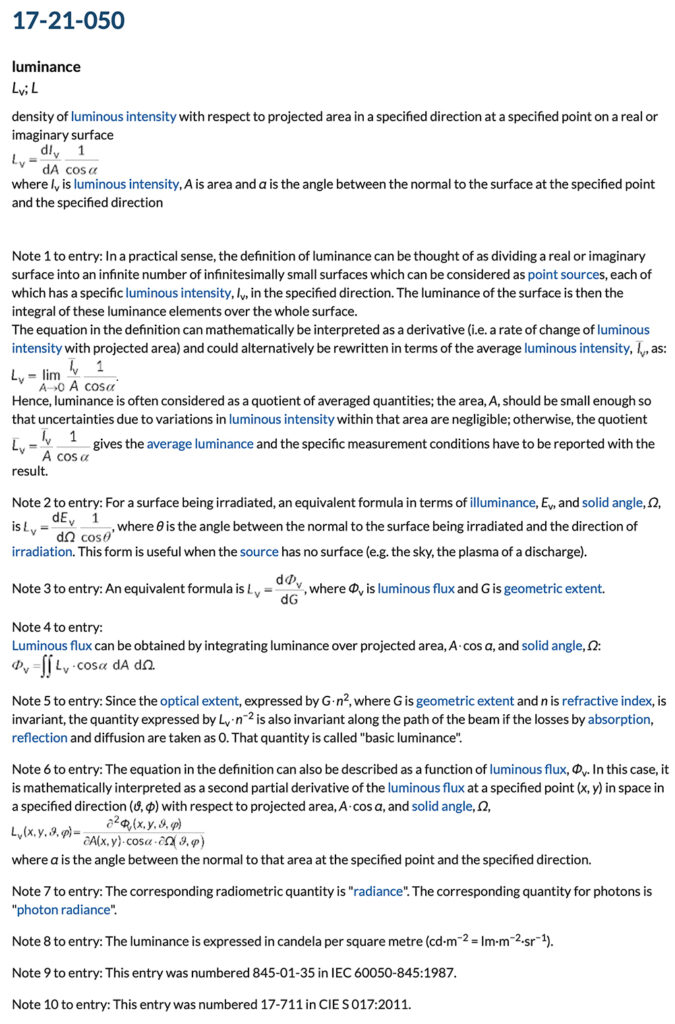

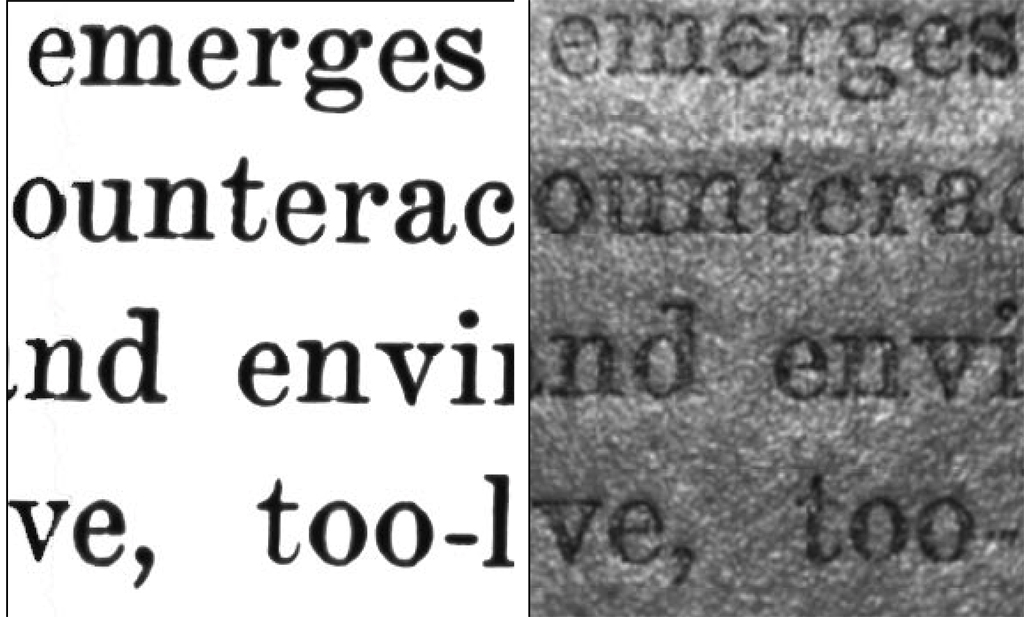

Der Leuchtdichte hingegen entspricht keine physikalische Größe, obwohl sie mit physikalischen Geräten gemessen wird. Wer genau wissen will, was sie ist, muss sich durch eine lange Definition kämpfen – und versteht am Ende … nichts. Spaßeshalber habe ich deren Definition aus dem CIE-Wörterbuch der Lichttechnik kopiert. Da sie nicht auf einen 4K-Monitor passte, musste ich das Bild verkleinern. Leider gibt die CIE selbst die Definition nicht mehr auf Deutsch (link). Hier ist das Prachtstück

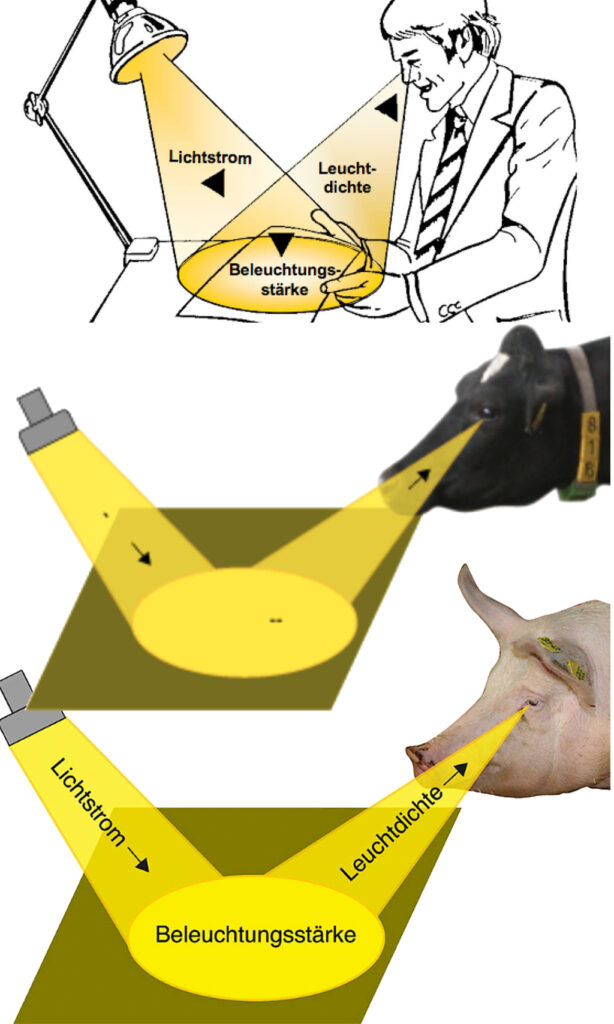

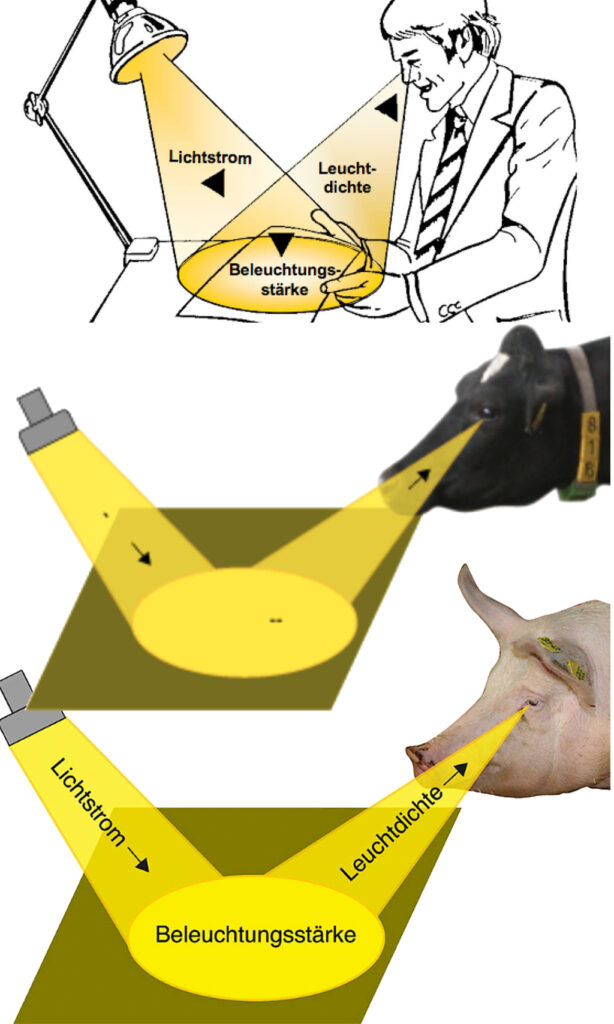

Diese wahnsinnig lange Definition ist leider nicht aus einer Unfähigkeit heraus entstanden. Sie ist der Komplexität der Größe zu verdanken. Fachleute wie Laien versuchen, sie erklärbar zu machen, und scheuen dabei keine Klimmzüge. Das älteste Bild, mit dem man sie erklären wollte, sieht aus wie hier.

Die Lampe der alten Dame beleuchtet den Tisch und erzeugt das, was ihr das Sehen ermöglicht: die Leuchtdichte. Da nicht nur alte Damen diese brauchen, gibt es die entsprechenden Bilder auch für andere. Ein Dutzend und mehr davon habe ich unter Wunder der Lichttechnik - Wie aus einer Grundgröße viele werden - kommentiert.

Die Lampe der alten Dame beleuchtet den Tisch und erzeugt das, was ihr das Sehen ermöglicht: die Leuchtdichte. Da nicht nur alte Damen diese brauchen, gibt es die entsprechenden Bilder auch für andere. Ein Dutzend und mehr davon habe ich unter Wunder der Lichttechnik - Wie aus einer Grundgröße viele werden - kommentiert.

Dabei entstehen Bilder, die sogar schlechter verständlich sind als die Definition. Hier habe ich drei Beispiele zusammengestellt, die besonders lustig aussehen. Oben sieht man einen Mann mit Kravatte, dessen Lampe aus der Zeit stammt, als er noch im Blaumann arbeitete, gezeichnet von einer BG. Die beiden unteren stammen auch von einer BG, aber sind mit der Landwirtschaft verbunden. Das letzte Bildchen erklärte dem Bauern die Vorschriften für die Beleuchtung von Sauställen.

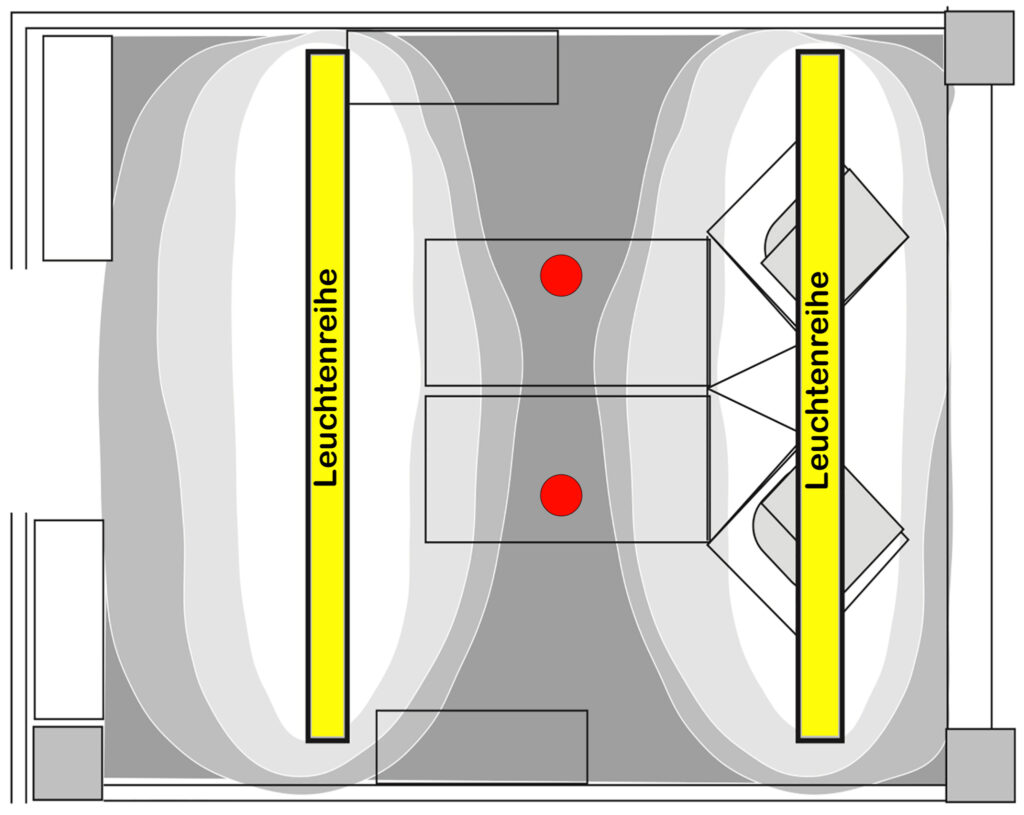

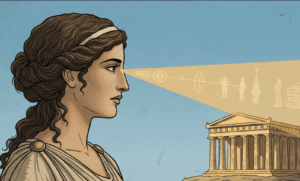

Links kommt ein Lichtstrom aus einer Lampe. Eigentlich hat er keine Richtung. Aber lassen wir das gelten. Dieser führt zu einer Beleuchtungsstärke. Eigentlich stellt das Oval keine Beleuchtungsstärke dar. Die ist nämlich gerichtet. Und daraus geht ein Strahl ins Auge des Schweins, der immer schmaler wird. Er sieht ähnlich aus wie der antike Lichtstrahl, der nach der damaligen Lehre vom Auge ausging und das Sehen ermöglichte. Wie dem auch sei, das Schwein sieht, wie die Kuh auch, nur dichromatisch, weil es nur zwei Farbempfänger im Auge hat. Menschen haben drei. Nur dafür kann eine Leuchtdichte berechnet werden. Für den Fall, dass sich Vogelliebhaber oder Aquarianer auch so ein Bild basteln: Vögel, Fische und Reptilien haben vier Farbempfänger im Auge.

Links kommt ein Lichtstrom aus einer Lampe. Eigentlich hat er keine Richtung. Aber lassen wir das gelten. Dieser führt zu einer Beleuchtungsstärke. Eigentlich stellt das Oval keine Beleuchtungsstärke dar. Die ist nämlich gerichtet. Und daraus geht ein Strahl ins Auge des Schweins, der immer schmaler wird. Er sieht ähnlich aus wie der antike Lichtstrahl, der nach der damaligen Lehre vom Auge ausging und das Sehen ermöglichte. Wie dem auch sei, das Schwein sieht, wie die Kuh auch, nur dichromatisch, weil es nur zwei Farbempfänger im Auge hat. Menschen haben drei. Nur dafür kann eine Leuchtdichte berechnet werden. Für den Fall, dass sich Vogelliebhaber oder Aquarianer auch so ein Bild basteln: Vögel, Fische und Reptilien haben vier Farbempfänger im Auge.

Aber auch verbale Erklärungen sind mehr oder weniger falsch. So erzählt mancher, Leuchtdichte sei Helligkeit. Wer es genauer machen will, bezeichnet sie als Größe, die der Helligkeit entspricht. In Licht.de liest man gar Kluges: „Die Leuchtdichte (Kurzzeichen: L) kann vom Auge wahrgenommen werden. Sie bestimmt den Helligkeitseindruck einer Fläche, der von Farbe und Material abhängt. Sagen wir netterweise, ganz falsch ist diese Umschreibung nicht. Aber auch nicht richtig. Was soll ein Mensch unter einem Helligkeitseindruck verstehen, der vom Material abhängt? Was hat das Material mit der Helligkeit zu tun? Und mit Farbe?

Solche Missverständnisse und Ungenauigkeiten wären nur für Fachleute interessant und für andere gleichgültig oder erträglich, wenn sie nicht zu Situationen führen, die unangenehm bis gefährlich sind. Zunächst zu einem alltäglichen Ärgernis. Manche Nachbarn stellen in ihrem Garten Scheinwerfer auf und denken, dass das Licht schwächer werde, wenn es den Nachbarn trifft. Das tut es, wenn man im Schlafzimmer die Beleuchtungsstärke misst, wie das Bundes-Immissionsschutzgesetz (BImSchG) vorgibt. Die zulässigen Werte variieren stark je nach Gebietsart (z.B. reine Wohngebiete: 1 lx, Kerngebiete/Gewerbegebiete: 5 lx).

Zwar wird in diesem Zusammenhang auch die Leuchtdichte genannt. Aber nicht einmal Fachleute können diese messen. So gibt es auch keine Grenzwerte. Das Messproblem ist nicht einmal eine erstrangig wichtige Sache. Die Wichtigere ist das mangelhafte Verständnis der Wirkung: Die Leuchtdichte ist die Konstante in einem optischen Strahlengang. Sie nimmt in der Luft kaum ab. Ihre Wirkung besteht so lange praktisch unverändert, bis die leuchtende Fläche klein genug scheint. Deswegen stören Sterne am nächtlichen Himmel trotz einer hohen Leuchtdichte nicht. Erst wenn sie eine Mindestgröße erreichen, wird ihre Leuchtdichte allein wirksam (Riccosches Gesetz).

Das Bundesimmissionsschutzgesetz begrenzt die Beleuchtungsstärke am Ort der Störung. Diese ist proportional der Fläche des störenden Objektes und dessen Leuchtdichte. Und nimmt mit dem Quadrat der Entfernung vom strahlenden Objekt ab. Das ist das übliche Verständnis von der Ausbreitung von Licht oder Schall. Dass die Leuchtdichte mit zunehmender Entfernung nicht abnimmt, ist niemandem bewusst. Auch nicht, dass sie in die Blendungsberechnung mit dem Quadrat ihres Wertes eingeht.

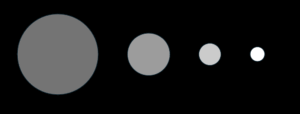

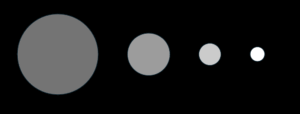

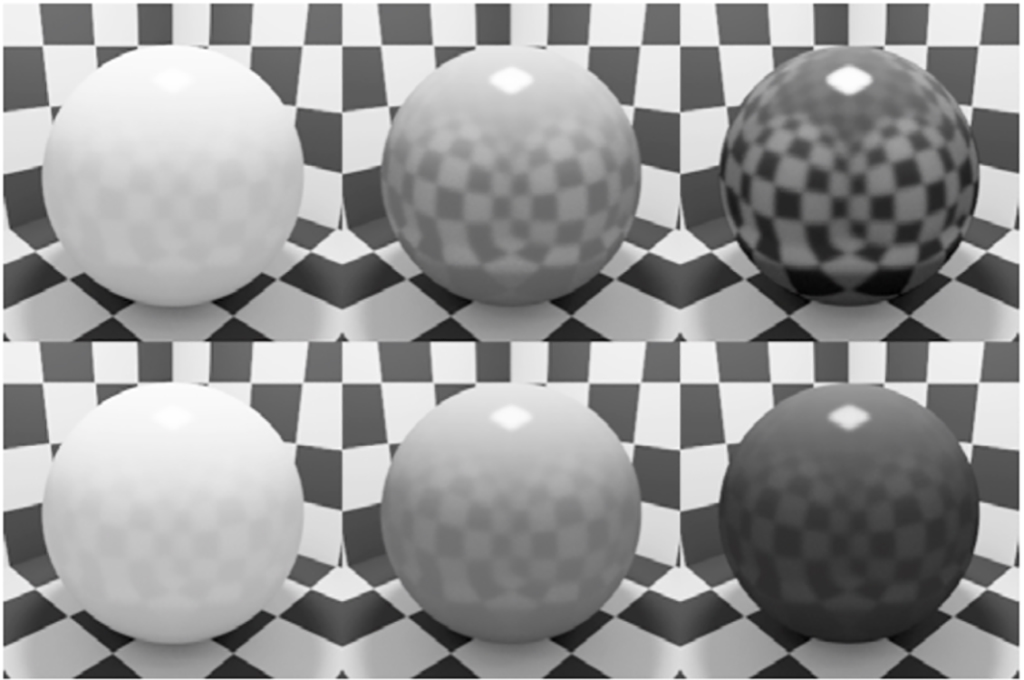

Folgende Objekte erzeugen am Einfallsort exakt die gleiche Beleuchtungsstärke. Ihre Blendwirkung ist aber sehr unterschiedlich und steigt mit dem Quadrat der Fläche. Daher kann Ihr Nachbar Sie mit einer Lampe stören, ohne gegen das Gesetz zu verstoßen. Und er ahnt nichts davon.

(Bitte um Nachsicht für die Abbildung. Man kann auf einem Bildschirm nur eine etwa annähernde Wirkung simulieren.)

(Bitte um Nachsicht für die Abbildung. Man kann auf einem Bildschirm nur eine etwa annähernde Wirkung simulieren.)

Echt gefährlich wird die Sache mit der Beleuchtung von Fahrzeugen. Da die Gefahr schon sehr früh bekannt war, wird deren Beleuchtung seit der Entstehung des motorisierten Verkehrs gesetzlich geregelt. In Deutschland waren die Vorschriften zur Fahrzeugbeleuchtung historisch in der Straßenverkehrs-Zulassungs-Ordnung (StVZO) verankert, die mehrmals neu gefasst wurde:

- Beginn 20. Jahrhundert: Schon mit dem Aufkommen der ersten Kraftwagen wurden Beleuchtungsvorschriften erlassen, die zunächst oft auf einfache Öllampen oder Karbidlampen abzielten.

- 1937: Die StVZO, die heute noch in Teilen gültig ist, enthielt detaillierte Regelungen zur Beleuchtung (§§ 49a - 54 StVZO).

Die StVZO enthält heute auch Vorschriften für die Beleuchtung von Fahrrädern. Da diese aber sehr schwache Lichtquellen waren, gibt es keine Prüfung wie bei den KfZ. Etwa jeder zweite Fehler, der bei KfZ-Prüfungen beanstandet wird, betrifft die Einstellung der Scheinwerfer, weil diese den Gegenverkehr blenden können. Bei Fahrrädern hingegen gibt es keine Prüfungen. Auch die Entwicklung von Fahrradbeleuchtung selbst wird kaum streng kontrolliert.

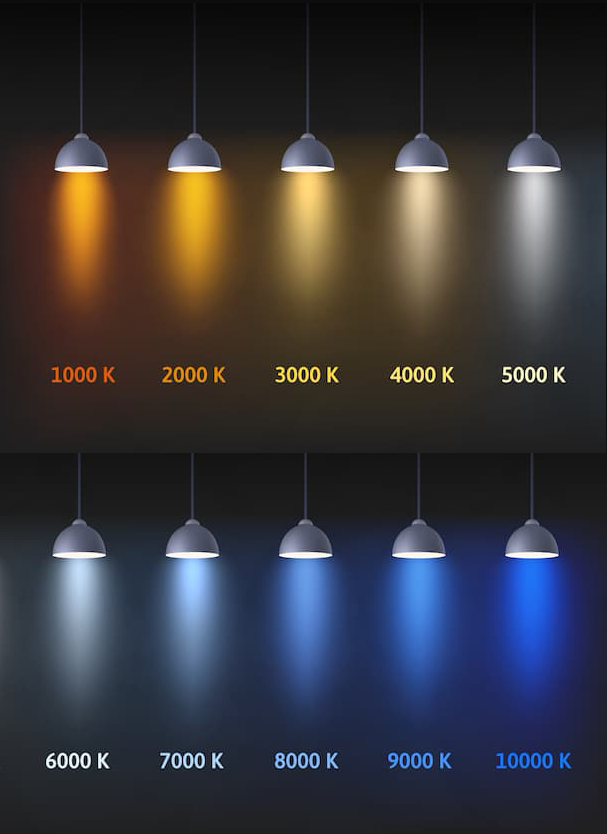

Das war auch nicht nötig, weil viele Beleuchtungen von Kleinrädern selbst in der Nacht kaum blendeten, weil sie einfach zu schwach waren. Zudem gingen sie aus, wenn das Fahrrad stand. Seit es LED-Lampen gibt, ist es aus mit den üblichen Eigenschaften. Da LEDs Leuchtdichten haben, die in die gleiche Größenordnung gehören wie die der Sonne, können Fahrradlichter einen bei Sonnenschein so blenden, dass man nichts mehr dahinter erkennen kann. (mehr unter Warum Autos so blenden)

Was ist der Kenntnisstand beim verantwortlichen Bundesministerium? Auf die kleine Anfrage der Abgeordneten zu „Gefahren im Straßenverkehr durch Blendeffekte von Leuchtdioden“ ließ er u.a. erklären: „Erkenntnisse über Gefahren, dass Fahrräder oder Motorräder mit Einzellicht durch Fahrzeuge mit ECE-genehmigten Tagfahrleuchten, die aus mehreren Einzeldioden bestehen, übersehen werden, sind nicht bekannt.“ (Drucksache 17/2307) (hier abrufbar. Anm.: Der Vorgang stammt zwar aus 2010, das Ministerium hat aber seit 1937 Manches nicht mehr gelernt)

Warum blenden dann die Scheinwerfer der Autos nicht, die viel größere Beleuchtungsstärken erzeugen? Um den Gegenverkehr nicht zu blenden, darf bei Fahrrädern die Beleuchtungsstärke bei 3,4 Grad oberhalb des hellsten Punktes des Lichtkegels 2 Lux nicht überschreiten. Aber Viele moderne, zugelassene LED-Fahrradscheinwerfer bieten heute Helligkeiten von 30 Lux, 50 Lux oder sogar über 100 Lux an, um eine bessere Sicht für den Fahrer zu gewährleisten.

Fahrradlampen sind sehr unterschiedlich befestigt, aber nur selten so unverrückbar wie bei Autos. Man kann die gleiche Lampe auf kleine oder große Fahrräder montieren und dazu noch frei ausrichten. Niemand kann sie kontrollieren, kaum einem Fahrer ist bewusst, dass sein Fahrrad stärker blendet als ein Auto.

Auch hier erfolgt die gesetzliche Regelung über die Beleuchtungsstärke, obwohl Fachleute schon immer wussten, dass die Blendung von der Leuchtdichte bestimmt wird.

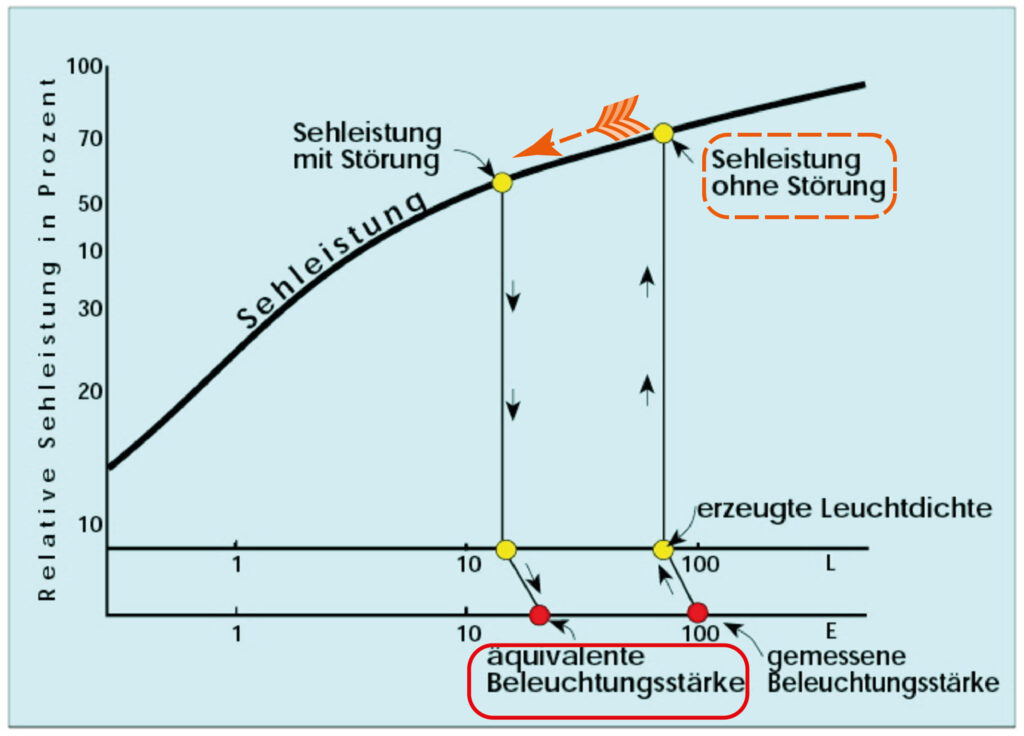

Die letzte Aussage bedarf einer Korrektur, die allerdings entscheidend für die Zulassung von Fahrzeugbeleuchtungen ist. Lichttechniker aus Karlsruhe, wo auch die Zulassungsstelle für die Fahrzeugbeleuchtung sitzt, haben zwei unzulässige Aussagen bezüglich Blendung getroffen. Die Erste heißt: Maßgeblich für die Sicherheit des Straßenverkehrs ist die physiologische Blendung. Dies beruht auf der Vorstellung, dass man damit die Störung der Sehleistung messe. Daher wäre die psychologische Blendung im Straßenverkehr unbedeutsam. Mit dieser Vorstellung verwarf der Bundesminister eine Kleine Anfrage im Bundestag.

Während man schon lange mit dieser Vorstellung lebt, ist die zweite unzulässige Aussage der Grund für die Zulassung des sog. Dränglerlichts. Diese wurde vor 35 Jahren in der Form von Xenon-Lampen auf den Markt gebracht und hat ein sehr hohes Potenzial für die Blendung des Gegenverkehrs. Deswegen mussten diverse Maßnahmen vorgeschrieben werden, um die Blendung zu vermeiden, so eine automatische Leuchtweiteregelung und eine Scheinwerferwaschanlage, weil schon Staubpartikel auf dem Scheinwerfer ausreichen, um den Gegenverkehr zu blenden.

Die Einführung dieser sehr bedenklichen Technologie, deren Beherrschung immer noch schwer ist, wurde möglich durch folgende Aussage: Für die physiologische Blendung ist die Lichtstärke maßgeblich, für die psychologische Blendung die Leuchtdichte. Daher wurde gesetzlich die Lichtstärke begrenzt. Bis heute! Bei den alten Scheinwerfern war der Unterschied egal, nicht so bei Xenon- oder LED-Scheinwerfern. Um die Blendung (physiologisch) gleich zu halten, kann man bei halb so großen Scheinwerfern eine doppelte Leuchtdichte vorsehen, bei einem Zehntel der Fläche ist die zehnfache Leuchtdichte zulässig. Bei der psychologischen Blendung geht die Leuchtdichte mit dem Quadrat in die Berechnung ein. Daher der Begriff „Dränglerlicht“.

Das Thema ist "aktenkundig" und wurde z.B. bei Lux Junior 2013 vorgetragen. Fazit: "Der Beitrag zeigt, dass die aktuelle Bewertung lichttechnischer Komponenten im Automobilbereich nicht die tatsächlich resultierende Blendung erfasst. Die angeführten Literaturquellen in Verbindung mit den Ergebnissen aus durchgeführten Voruntersuchungen verdeutlichen, dass ein Scheinwerfer ein wesentlich höheres Blendpotential aufweisen kann, als durch die gesetzeskonforme Abnahme ermittelt wird."

Zu guter Letzt noch eine Beleuchtung, die die Sicherheit im Straßenverkehr erhöhen soll, aber nach Ansicht von Augenärzten das Gegenteil erreicht. Die Rede ist von Tagfahrlichtern. Diese sind seit Langem vorgeschrieben. Anders als die übliche Beleuchtung, die zum Sehen und Gesehenwerden dient, dienen Tagfahrlichter nur zum Gesehenwerden. Sie hängen vorn am Fahrzeug, damit es gesehen wird. Auch deren Licht wird gesetzlich über die Lichtstärke geregelt. Dummerweise hat die Lichtstärke selten etwas mit Sichtbarkeit zu tun. Dafür sorgen am besten die Farbe, die Größe oder die Leuchtdichte.

Bei Tagfahrlichtern gibt es so schlimme Exemplare, dass ich in meinem Arbeitszimmer im ersten Stock geblendet werde, wenn ein Auto auf uns zukommt. Die Lichter stören sogar am Tage sechs Meter über der Straße. Für die Blendung bestens sorgt wieder die Leuchtdichte der LED.

Auch dieser Effekt ist aktenkundig. Auf eine Anfrage von Abgeordneten (Drucksache 17/2042) antwortete der Verkehrsminister einst so: "Wissenschaftliche Erkenntnisse oder Forschungsberichte zur Blendung durch Tagfahrleuchten mit Leuchtdioden sind der Bundesregierung nicht bekannt. " (mehr hier) Dabei hatte Peter Heilig, Augenarzt, die Sache aus der Sicht eines Augenarztes dokumentiert (hier)

Eine Gruppe von Augenärzten hatte schon vor 10 Jahren Front gegen „zu helle“ Scheinwerfer gemacht, die man z.B. hier lesen kann. Dem Bundesverkehrsminister, der sich ahnungslos stellte, war die Sache aber schon bekannt. Die folgende Frage hat er nach der einstigen Kenntnislage nämlich so beantwortet:

„2. Wie bewertet es die Bundesregierung, dass sich zunehmend Verkehrsteilnehmer durch starke Lichteinwirkung von Leuchtdioden geblendet fühlen und dadurch im Straßenverkehr verunsichert werden?"

Antwort: "In der Wissenschaft wird unterschieden zwischen physiologischer und psychologischer Blendung. Die physiologische Blendung setzt die Sehleistung des Auges herab. Bei der psychologischen Blendung wird eine Blendungserhöhung empfunden, die nicht messbar und individuell verschieden ist. Verkehrsteilnehmer können sich geblendet fühlen, ohne dass dies zu einer verringerten Sehleistung führt.“

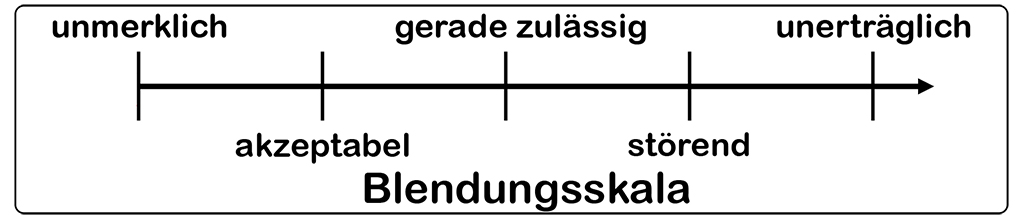

So antwortete der Bundesverkehrsminister am 28.06.2010. Nicht ganz wahrheitsgemäß. Die psychologische Blendung ist nach der Vorstellung der Industrie so gut messbar, dass sie Werte für ihre Leuchten (UGR-Wert) dreistellig angibt.

Und so wertete jemand, der sich schon sehr lange mit dem Problem beschäftigt hatte, Professor Stephan Völker, TU Berlin, am 11. September 2012 (Blendung – Ein Rückblick über 100 Jahre Forschung, Tagungsband Light 2012, 20. Gemeinschaftstagung LiTG, NSV, LtG, SLG): „Der vorliegende Beitrag zeigt, dass es möglich scheint, die vorhandenen Blendungsbewertungsmodelle auf ein Modell zurückzuführen. Zurzeit fehlen noch einige Einflussgrößen, welche aber bereits in Kürze vorliegen dürften. Diese müssen anschließend für alle Anwendungsfälle (Innen-, Außen-, Kfz-, Sportstättenbeleuchtung, etc.) validiert werden.“

Kurz gesagt: Die Vorstellung von zwei unterschiedlichen Arten der Blendung kann nicht mehr aufrechterhalten werden. Man kann ein neues Verfahren finden. Dieses muss danach validiert werden. D.h., die jetzige Vorstellung ist ungültig. Ob sie jemals gültig gewesen ist, darauf sollte man besser nicht wetten.

Die hier dargestellte Problematik ist nicht eines unter vielen. Denn Blendung im Straßenverkehr gehört in die hohe Politik. So wollte der damalige Verkehrsminister Georg Leber 1972 die Führerscheine älterer Bürger zeitlich begrenzen und von einer Prüfung der Blendempfindlichkeit abhängig machen. Faktisch gab es kein objektives Argument dagegen. Die Maßnahme unterblieb nur wegen der hohen Bedeutung der Mobilität für ältere Menschen. Mittlerweile ist der durchschnittliche Deutsche 10 Jahre älter als 1972 (mittleres Alter 35,5 Jahre (1972) und 44,9 Jahre (2024)), wobei sich der Anteil der Bevölkerung ab 65 Jahren fast verdoppelt hat (ca. 13% 1972 und ca. 22% 2024). Fahrräder und Autos dürfen aber fröhlich blenden, weil die Vorstellungen des Gesetzgebers auf wissenschaftlichen Erkenntnissen fußen, die spätestens vor 10 Jahren als falsch und nicht valide erkannt worden sind. Hinzu kommt, dass der Bundesminister eine unwahre Angabe macht.

Und die Folgen? Eine ADAC Umfrage mit 1.089 Personen mit gültiger Fahrerlaubnis ergab:

- 67 % der befragten Personen empfinden die erlebte Blendung als untragbar oder störend.

- 60 % aller Teilnehmer haben Probleme, Objekte im Umfeld der blendenden Lichtquelle wahrzunehmen.

- 49 % der Befragten kneifen die Augen zu, wenn sie der Blendung ausgesetzt sind, oder schließen sie sogar kurz.

- 27 % der Umfrageteilnehmer fühlen sich fast immer oder regelmäßig geblendet.

- 27 % der Befragten gaben an, ein Bild der Lichtquelle auch nach dem Passieren für eine begrenzte Zeit weiterhin zu sehen (Nachbild) oder sogar Schmerzen zu empfinden.

(ADAC e.V., Hg., "Verbraucherumfrage Blendung im Straßenverkehr", München, 2024) Die obigen Daten stammen aus Lux Junior 2024. Die KI fasst das Ergebnis wie folgt zusammen: "Eine repräsentative Umfrage des ADAC ergab, dass über 90 % der Autofahrenden im Straßenverkehr geblendet werden, wobei fast zwei Drittel dies als störend empfinden. Besonders problematisch sind dabei das Fernlicht und moderne Scheinwerfertechnologien wie LED, die zu Blendung führen, da sie oft eine höhere Leuchtkraft und Platzierung haben."

Der ADAC selber gab am 3. September 2025 eine Meldung über die Situation in ganz Europa heraus: "Gefahr durch Blendung: Viele Autofahrer sind betroffen." (mehr hier)

Die Lampe der alten Dame beleuchtet den Tisch und erzeugt das, was ihr das Sehen ermöglicht: die Leuchtdichte. Da nicht nur alte Damen diese brauchen, gibt es die entsprechenden Bilder auch für andere. Ein Dutzend und mehr davon habe ich unter

Die Lampe der alten Dame beleuchtet den Tisch und erzeugt das, was ihr das Sehen ermöglicht: die Leuchtdichte. Da nicht nur alte Damen diese brauchen, gibt es die entsprechenden Bilder auch für andere. Ein Dutzend und mehr davon habe ich unter  Links kommt ein Lichtstrom aus einer Lampe. Eigentlich hat er keine Richtung. Aber lassen wir das gelten. Dieser führt zu einer Beleuchtungsstärke. Eigentlich stellt das Oval keine Beleuchtungsstärke dar. Die ist nämlich gerichtet. Und daraus geht ein Strahl ins Auge des Schweins, der immer schmaler wird. Er sieht ähnlich aus wie der antike Lichtstrahl, der nach der damaligen Lehre vom Auge ausging und das Sehen ermöglichte. Wie dem auch sei, das Schwein sieht, wie die Kuh auch, nur dichromatisch, weil es nur zwei Farbempfänger im Auge hat. Menschen haben drei. Nur dafür kann eine Leuchtdichte berechnet werden. Für den Fall, dass sich Vogelliebhaber oder Aquarianer auch so ein Bild basteln: Vögel, Fische und Reptilien haben vier Farbempfänger im Auge.

Links kommt ein Lichtstrom aus einer Lampe. Eigentlich hat er keine Richtung. Aber lassen wir das gelten. Dieser führt zu einer Beleuchtungsstärke. Eigentlich stellt das Oval keine Beleuchtungsstärke dar. Die ist nämlich gerichtet. Und daraus geht ein Strahl ins Auge des Schweins, der immer schmaler wird. Er sieht ähnlich aus wie der antike Lichtstrahl, der nach der damaligen Lehre vom Auge ausging und das Sehen ermöglichte. Wie dem auch sei, das Schwein sieht, wie die Kuh auch, nur dichromatisch, weil es nur zwei Farbempfänger im Auge hat. Menschen haben drei. Nur dafür kann eine Leuchtdichte berechnet werden. Für den Fall, dass sich Vogelliebhaber oder Aquarianer auch so ein Bild basteln: Vögel, Fische und Reptilien haben vier Farbempfänger im Auge.

Es gibt aber Fälle, wo man am Sehen gestört wird und die Sache unangenehm findet, die aber trotzdem nicht Blendung heißen. Aber erst einmal zu einer Situation, die äußerst angenehm ist, aber mit Blendung, besser gesagt, die Blendung merkt keiner.

Es gibt aber Fälle, wo man am Sehen gestört wird und die Sache unangenehm findet, die aber trotzdem nicht Blendung heißen. Aber erst einmal zu einer Situation, die äußerst angenehm ist, aber mit Blendung, besser gesagt, die Blendung merkt keiner.

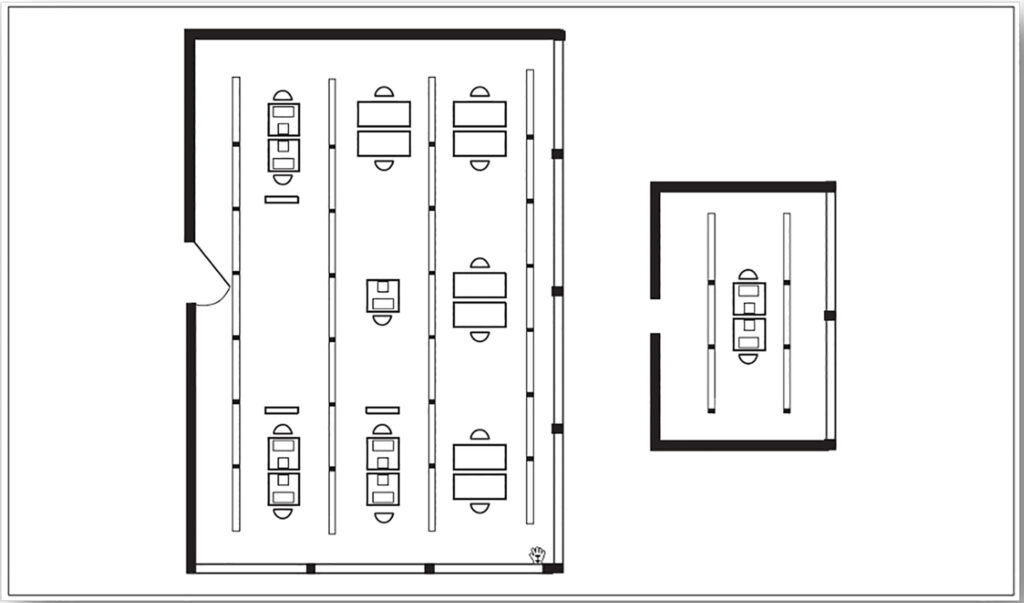

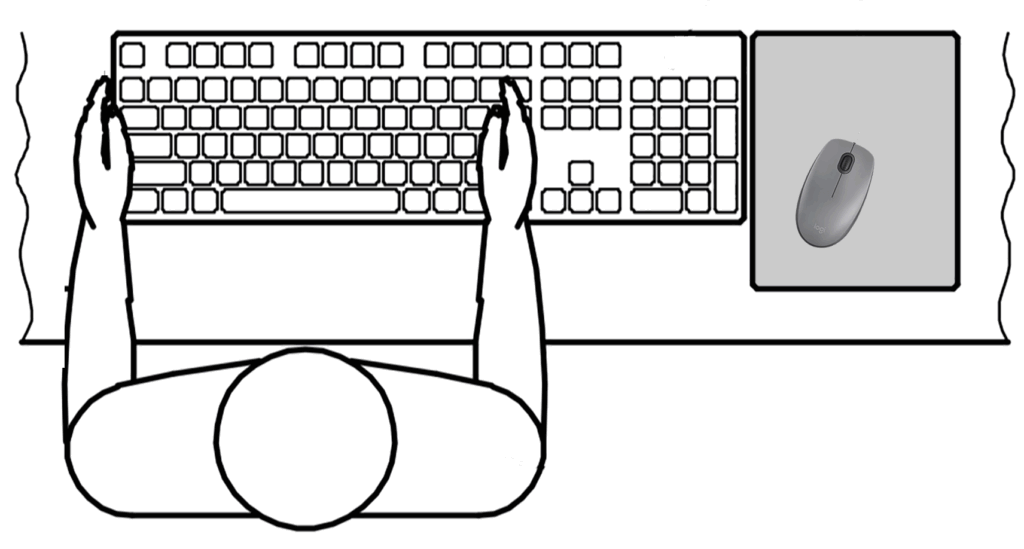

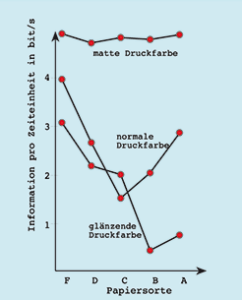

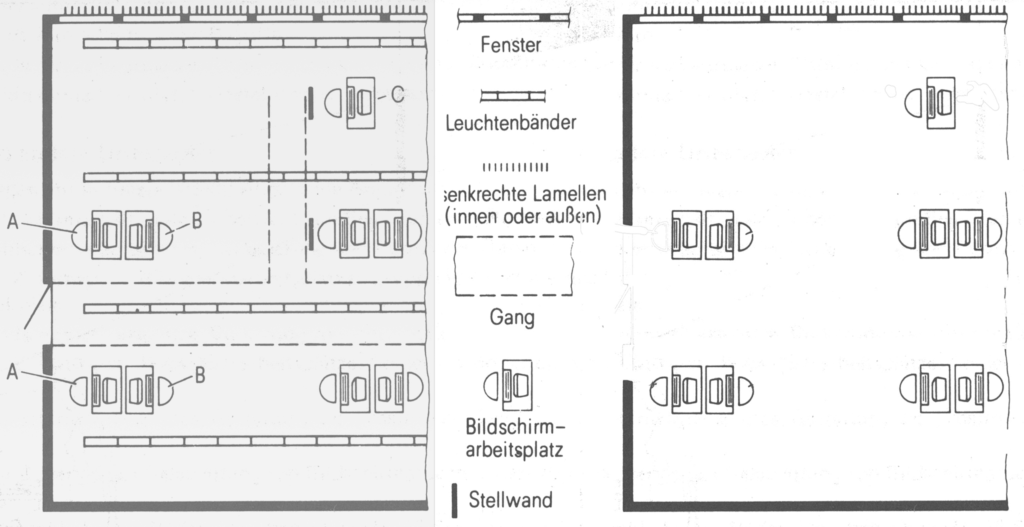

In der Regel merkt man den Effekt nicht bewusst. Man kann ihn durch vergleichende Untersuchungen unter der gleichen Beleuchtung mit und ohne Sehaufgabe ermitteln. Wenn der Effekt da ist, ermüden die Probanden stärker. Die Rede ist von einer verminderten Wiedergabe des Kontrastes. Man bestimmt sie in einer vergleichenden Messung unter idealen Bedingungen und in der realen Situation. Das Ergebnis ist der Kontrastwiedergabefaktor. Dessen Bedeutung wurde von den Experten der LiTG so hoch eingeschätzt, dass sie schon sehr frühzeitig eine Arbeitsgruppe an eine Publikation setzte (LiTG-Publikation Nr. 13 Der Kontrastwiedergabefaktor CRF – ein Gütemerkmal der Innenraumbeleuchtung, 1991).

In der Regel merkt man den Effekt nicht bewusst. Man kann ihn durch vergleichende Untersuchungen unter der gleichen Beleuchtung mit und ohne Sehaufgabe ermitteln. Wenn der Effekt da ist, ermüden die Probanden stärker. Die Rede ist von einer verminderten Wiedergabe des Kontrastes. Man bestimmt sie in einer vergleichenden Messung unter idealen Bedingungen und in der realen Situation. Das Ergebnis ist der Kontrastwiedergabefaktor. Dessen Bedeutung wurde von den Experten der LiTG so hoch eingeschätzt, dass sie schon sehr frühzeitig eine Arbeitsgruppe an eine Publikation setzte (LiTG-Publikation Nr. 13 Der Kontrastwiedergabefaktor CRF – ein Gütemerkmal der Innenraumbeleuchtung, 1991).

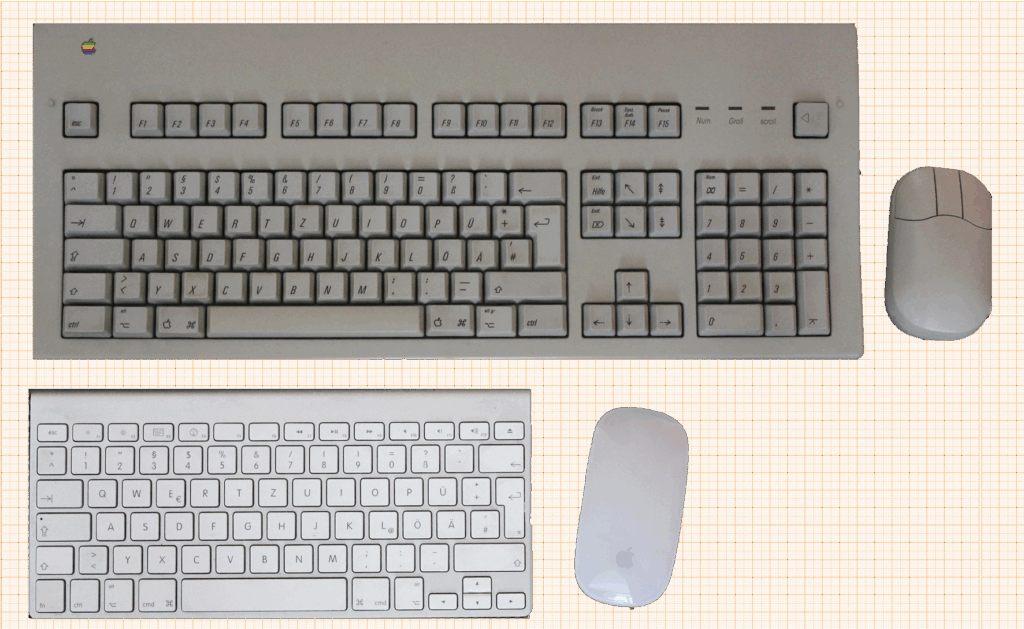

All diese Menschen benutzen ein zu kleines Display für ihren Bedarf, weil dieses in eine Hand passen muss. Und es gibt niemanden, der sich um ihre Beleuchtung kümmert. Bis auf wenige Ausnahmen sind die Displays schlecht geschützt gegen Licht. Der öffentliche Raum ist voller Menschen, die alle so gucken wie hier.

All diese Menschen benutzen ein zu kleines Display für ihren Bedarf, weil dieses in eine Hand passen muss. Und es gibt niemanden, der sich um ihre Beleuchtung kümmert. Bis auf wenige Ausnahmen sind die Displays schlecht geschützt gegen Licht. Der öffentliche Raum ist voller Menschen, die alle so gucken wie hier.

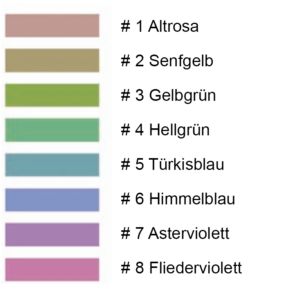

Nichts dergleichen ist wahr. Es werden diese trüben Farbmuster nach Meinung der Prüfer wiedergegeben, von denen niemand weiß, wo sie sitzen. Keine einzige gesättigte Farbe geht in die Prüfung ein. Zu guter Letzt sollen die Originale der gezeigten Farbmuster unauffindbar sein. Wenn Sie also demnächst im Baumarkt eine Lampe kaufen, sollten Sie wissen, was die Angabe CRI bzw. Ra bedeutet bzw. nicht bedeutet.

Nichts dergleichen ist wahr. Es werden diese trüben Farbmuster nach Meinung der Prüfer wiedergegeben, von denen niemand weiß, wo sie sitzen. Keine einzige gesättigte Farbe geht in die Prüfung ein. Zu guter Letzt sollen die Originale der gezeigten Farbmuster unauffindbar sein. Wenn Sie also demnächst im Baumarkt eine Lampe kaufen, sollten Sie wissen, was die Angabe CRI bzw. Ra bedeutet bzw. nicht bedeutet.

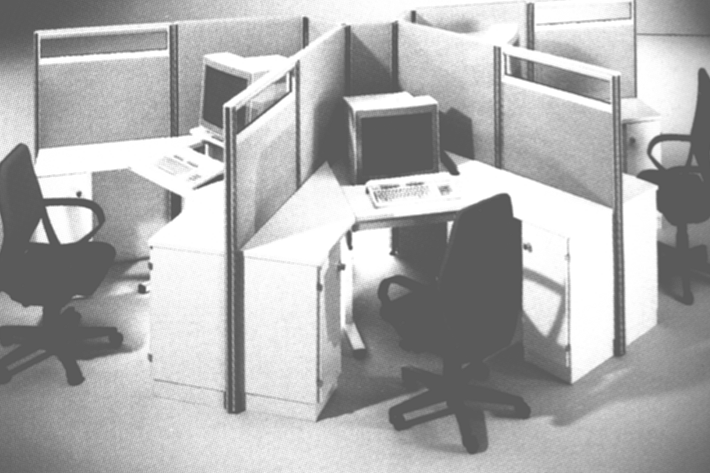

Der erste der Missetäter ist das liebe Geld. Dessen Bedeutung erklärte mir ein Leuchtenentwickler, als ich ihm (und seinesgleichen) vorwarf, Lichtteppiche zu planen. Er seufzte und sagte: “Wir wären froh, wenn die Bauherren Licht wie Teppiche behandelten. Mit einem festen Budget und bereits früh in der Planung.“ Und er erklärte weiter, dass bei der Planung eines Bürohauses der Teppich recht oben anstünde und etwa mit dem vierfachen Wert pro Quadratmeter wie Licht verplant würde. So falsch lag er damit nicht. Man kann zwar keine Qualität erwarten, wenn man sinnlos Geld ausgibt. Aber von selbst entsteht auch keine Qualität.

Der erste der Missetäter ist das liebe Geld. Dessen Bedeutung erklärte mir ein Leuchtenentwickler, als ich ihm (und seinesgleichen) vorwarf, Lichtteppiche zu planen. Er seufzte und sagte: “Wir wären froh, wenn die Bauherren Licht wie Teppiche behandelten. Mit einem festen Budget und bereits früh in der Planung.“ Und er erklärte weiter, dass bei der Planung eines Bürohauses der Teppich recht oben anstünde und etwa mit dem vierfachen Wert pro Quadratmeter wie Licht verplant würde. So falsch lag er damit nicht. Man kann zwar keine Qualität erwarten, wenn man sinnlos Geld ausgibt. Aber von selbst entsteht auch keine Qualität.

Über das Phoebus-Kartell wie über die geplante Obsoleszenz kursieren unzählige Legenden oder Gerüchte. Ich habe versucht, den wahren Kern verständlich zu machen, damit sich jeder seine Meinung bilden kann. Dazu schrieb ich in

Über das Phoebus-Kartell wie über die geplante Obsoleszenz kursieren unzählige Legenden oder Gerüchte. Ich habe versucht, den wahren Kern verständlich zu machen, damit sich jeder seine Meinung bilden kann. Dazu schrieb ich in